5.7 KiB

English | 简体中文 | 日本語 | Español | Klingon

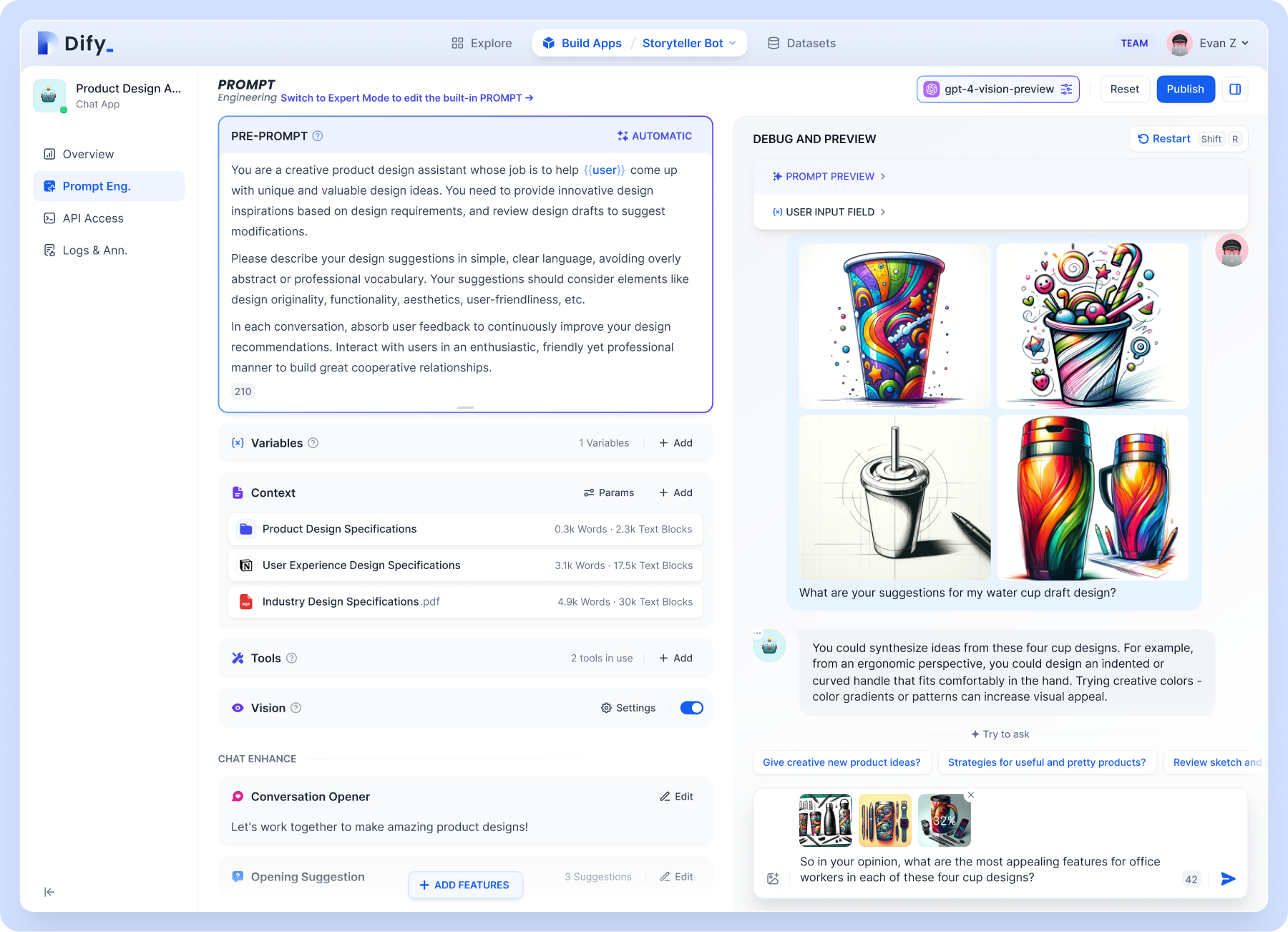

Dify 是一个 LLM 应用开发平台,已经有超过 10 万个应用基于 Dify.AI 构建。它融合了 Backend as Service 和 LLMOps 的理念,涵盖了构建生成式 AI 原生应用所需的核心技术栈,包括一个内置 RAG 引擎。使用 Dify,你可以基于任何模型自部署类似 Assistants API 和 GPTs 的能力。

为什么选择 Dify

Dify 具有模型中立性,相较 LangChain 等硬编码开发库 Dify 是一个完整的、工程化的技术栈,而相较于 OpenAI 的 Assistants API 你可以完全将服务部署在本地。

| 功能 | Dify.AI | Assistants API | LangChain |

|---|---|---|---|

| 编程方式 | 面向 API | 面向 API | 面向 Python 代码 |

| 生态策略 | 开源 | 封闭且商用 | 开源 |

| RAG 引擎 | 支持 | 支持 | 不支持 |

| Prompt IDE | 包含 | 包含 | 没有 |

| 支持的 LLMs | 丰富 | 仅 GPT | 丰富 |

| 本地部署 | 支持 | 不支持 | 不适用 |

特点

1. LLM支持:与 OpenAI 的 GPT 系列模型集成,或者与开源的 Llama2 系列模型集成。事实上,Dify支持主流的商业模型和开源模型(本地部署或基于 MaaS)。

2. Prompt IDE:和团队一起在 Dify 协作,通过可视化的 Prompt 和应用编排工具开发 AI 应用。 支持无缝切换多种大型语言模型。

3. RAG引擎:包括各种基于全文索引或向量数据库嵌入的 RAG 能力,允许直接上传 PDF、TXT 等各种文本格式。

4. Agent:基于函数调用的 Agent框架,允许用户自定义配置,所见即所得。Dify 提供了基本的插件能力,如谷歌搜索。

5. 持续运营:监控和分析应用日志和性能,使用生产数据持续改进 Prompt、数据集或模型。

在开始之前

安装社区版

系统要求

在安装 Dify 之前,请确保您的机器满足以下最低系统要求:

- CPU >= 2 Core

- RAM >= 4GB

快速启动

启动 Dify 服务器的最简单方法是运行我们的 docker-compose.yml 文件。在运行安装命令之前,请确保您的机器上安装了 Docker 和 Docker Compose:

cd docker

docker compose up -d

运行后,可以在浏览器上访问 http://localhost/install 进入 Dify 控制台并开始初始化安装操作。

Helm Chart

非常感谢 @BorisPolonsky 为我们提供了一个 Helm Chart 版本,可以在 Kubernetes 上部署 Dify。 您可以前往 https://github.com/BorisPolonsky/dify-helm 来获取部署信息。

配置

如果您需要自定义配置,请参考我们的 docker-compose.yml 文件中的注释,并手动设置环境配置。更改后,请再次运行 docker-compose up -d。您可以在我们的文档中查看所有环境变量的完整列表。

Star History

社区与支持

我们欢迎您为 Dify 做出贡献,以帮助改善 Dify。包括:提交代码、问题、新想法,或分享您基于 Dify 创建的有趣且有用的 AI 应用程序。同时,我们也欢迎您在不同的活动、会议和社交媒体上分享 Dify。

- GitHub Issues。👉:使用 Dify.AI 时遇到的错误和问题,请参阅贡献指南。

- 电子邮件支持。👉:关于使用 Dify.AI 的问题。

- Discord。👉:分享您的应用程序并与社区交流。

- Twitter。👉:分享您的应用程序并与社区交流。

- 商业许可。👉:有关商业用途许可 Dify.AI 的商业咨询。

- 微信 👉:扫描下方二维码,添加微信好友,备注 Dify,我们将邀请您加入 Dify 社区。

安全问题

为了保护您的隐私,请避免在 GitHub 上发布安全问题。发送问题至 security@dify.ai,我们将为您做更细致的解答。

License

本仓库遵循 Dify Open Source License 开源协议。